想象一下,你正在国外拜访一个朋友,你看看他们的冰箱里,看看什么会做一顿丰盛的早餐。许多物品最初对您来说似乎是陌生的,每件物品都装在不熟悉的包装和容器中。尽管有这些视觉上的区别,但你开始了解每个的用途,并根据需要拿起它们。

受到人类处理陌生物体的能力的启发,麻省理工学院计算机科学与人工智能实验室(CSAIL)的一个小组设计了机器人操作的特征场(F3RM),该系统将2D图像与基础模型特征融合到3D场景中,以帮助机器人识别和抓取附近的物品。F3RM 可以解释来自人类的开放式语言提示,使该方法在包含数千个对象(如仓库和家庭)的现实环境中很有帮助。

F3RM 使机器人能够使用自然语言解释开放式文本提示,帮助机器操纵对象。因此,机器可以理解人类不太具体的请求,并且仍然完成所需的任务。例如,如果用户要求机器人“拿起一个高杯子”,机器人可以找到并抓住最适合该描述的物品。

“制造能够在现实世界中真正泛化的机器人是非常困难的,”美国国家科学基金会人工智能与基础交互研究所和麻省理工学院CSAIL的博士后Ge Yang说。“我们真的很想弄清楚如何做到这一点,所以通过这个项目,我们试图推动一个激进的泛化水平,从只有三到四个物体到我们在麻省理工学院的Stata中心找到的任何东西。我们想学习如何让机器人像我们一样灵活,因为即使我们以前从未见过它们,我们也可以抓取和放置物体。

通过观察来学习“在哪里”

该方法可以帮助机器人在大型履行中心拣选物品,这些物品不可避免地会变得混乱和不可预测。在这些仓库中,机器人通常会被赋予他们需要识别的库存描述。无论包装如何变化,机器人都必须与提供给物体的文本相匹配,以便正确运送客户的订单。

例如,主要在线零售商的履行中心可能包含数百万件商品,其中许多商品是机器人以前从未遇到过的。为了在这样的规模下操作,机器人需要了解不同物品的几何形状和语义,有些物品在狭小的空间内。借助 F3RM 先进的空间和语义感知能力,机器人可以更有效地定位物体,将其放入垃圾箱,然后将其送去包装。最终,这将帮助工厂工人更有效地运送客户的订单。

“F3RM经常让人们感到惊讶的一件事是,同样的系统也可以在房间和建筑规模上工作,并且可用于构建机器人学习和大地图的模拟环境,”Yang说。“但在我们进一步扩大这项工作之前,我们希望首先让这个系统运行得非常快。这样,我们就可以将这种类型的表示用于更动态的机器人控制任务,希望是实时的,这样处理更多动态任务的机器人就可以使用它进行感知。

麻省理工学院的团队指出,F3RM理解不同场景的能力可能使其在城市和家庭环境中有用。例如,这种方法可以帮助个性化机器人识别和拾取特定物品。该系统帮助机器人掌握周围环境——无论是身体上还是感知上。

“大卫·马尔(David Marr)将视觉感知定义为’通过观察来了解什么在哪里’的问题,”资深作者,麻省理工学院电气工程和计算机科学副教授兼CSAIL首席研究员Phillip Isola说。“最近的基础模型非常善于知道他们在看什么;它们可以识别数以千计的对象类别,并提供图像的详细文本描述。同时,辐射场在表示场景中物体的位置方面也变得非常出色。这两种方法的结合可以创建3D中位置的表示,我们的工作表明,这种组合对于需要在3D中操纵物体的机器人任务特别有用。

创建“数字孪生”

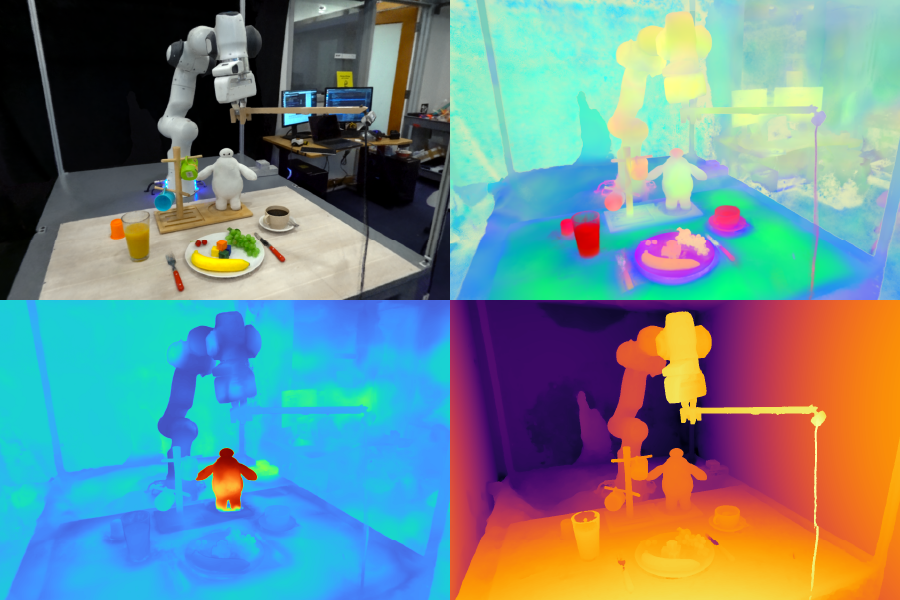

F3RM开始通过在自拍杆上拍照来了解周围的环境。安装的相机以不同的姿势拍摄 50 张图像,使其能够构建神经辐射场 (NeRF),这是一种利用 2D 图像构建 3D 场景的深度学习方法。这种RGB照片的拼贴画以360度表示附近事物的形式创建了周围环境的“数字孪生”。

除了高度详细的神经辐射场外,F3RM 还构建了一个特征场,以使用语义信息增强几何图形。该系统使用CLIP,这是一种在数亿张图像上训练的视觉基础模型,可以有效地学习视觉概念。通过为自拍杆拍摄的图像重建 2D CLIP 特征,F3RM 有效地将 2D 特征提升为 3D 表示。

保持开放性

在接受了一些演示后,机器人应用它对几何和语义的了解来抓取它以前从未遇到过的物体。一旦用户提交了文本查询,机器人就会搜索可能的抓取空间,以识别那些最有可能成功拾取用户请求的对象的人。每个潜在选项都根据其与提示的相关性、与机器人训练的演示的相似性以及它是否引起任何碰撞进行评分。然后选择并执行得分最高的抓握。

为了证明该系统能够解释来自人类的开放式请求,研究人员提示机器人拿起迪士尼“大英雄6”中的角色Baymax。虽然 F3RM 从未接受过直接训练来捡起卡通超级英雄的玩具,但机器人利用其来自基础模型的空间感知和视觉语言特征来决定抓取哪个物体以及如何捡起它。

F3RM 还使用户能够指定他们希望机器人在不同语言细节级别处理的对象。例如,如果有一个金属杯和一个玻璃杯,用户可以向机器人索要“玻璃杯”。如果机器人看到两个玻璃杯,其中一个装满了咖啡,另一个装满了果汁,用户可以要求“玻璃杯里装咖啡”。嵌入在特征字段中的基础模型特征可实现这种级别的开放式理解。

“如果我向一个人展示如何从嘴唇上拿起杯子,他们可以很容易地将这些知识转移到具有相似几何形状的物体上,例如碗、量杯,甚至是卷尺。对于机器人来说,实现这种适应性水平是相当具有挑战性的,“麻省理工学院博士生、CSAIL附属机构和共同主要作者William Shen说。“F3RM将几何理解与基于互联网规模数据训练的基础模型的语义相结合,只需少量演示即可实现这种程度的积极泛化。”

Shen和Yang在Isola的指导下撰写了这篇论文,麻省理工学院教授和CSAIL首席研究员Leslie Pack Kaelbling以及本科生Alan Yu和Jansen Wong是合著者。该团队得到了 Amazon.com 服务、美国国家科学基金会、空军科学研究办公室、海军研究办公室多学科大学计划、陆军研究办公室、麻省理工学院-IBM Watson实验室和麻省理工学院情报探索的部分支持。他们的工作将在 2023 年机器人学习会议上展示。

新闻旨在传播有益信息,英文版原文来自https://news.mit.edu/2023/using-language-give-robots-better-grasp-open-ended-world-1102