帕特·贝内特(Pat Bennett)的处方比“服用几片阿司匹林,早上给我打电话”要复杂一些。但是,植入她大脑的四颗婴儿阿司匹林大小的传感器旨在解决让她和其他人感到沮丧的情况:失去可理解的说话能力。这些设备将信号从贝内特大脑中几个与语音相关的区域传输到最先进的软件,该软件解码她的大脑活动并将其转换为计算机屏幕上显示的文本。

现年68岁的贝内特是一名前人力资源总监,曾经是马术运动员,每天慢跑。2012年,她被诊断出患有肌萎缩侧索硬化症,这是一种进行性神经退行性疾病,会攻击控制运动的神经元,导致身体虚弱并最终瘫痪。

“当你想到ALS时,你会想到手臂和腿部的影响,”贝内特在通过电子邮件进行的采访中写道。“但在一组ALS患者中,它始于言语困难。我说不出话来。

通常,ALS首先表现在身体的外围 – 手臂和腿,手和手指。对于贝内特来说,恶化不是像典型的那样始于她的脊髓,而是始于她的脑干。她仍然可以四处走动,自己穿衣服,用手指打字,尽管难度越来越大。但她不能再用嘴唇、舌头、喉部和下颚的肌肉来清楚地表达音素——或声音单位,如 sh ——它们是语音的基石。

虽然贝内特的大脑仍然可以制定生成这些音素的方向,但她的肌肉无法执行这些命令。

2022 年 3 月 29 日,斯坦福医学院的一位神经外科医生将两个微型传感器分别放置在贝内特大脑表面的两个不同区域——这两个区域都与语音产生有关。传感器是皮层内脑机接口(iBCI)的组成部分。结合最先进的解码软件,它们旨在将伴随语音尝试的大脑活动翻译成屏幕上的单词。

手术后大约一个月,斯坦福大学的一组科学家开始每周两次进行研究会议,以训练解释她演讲的软件。四个月后,贝内特尝试的话语以每分钟62个单词的速度在计算机屏幕上转换为单词 – 是之前BCI辅助通信记录的三倍多。

“这些初步结果已经证明了这个概念,最终技术将迎头赶上,使那些不会说话的人更容易获得它,”贝内特写道。“对于那些不会说话的人来说,这意味着他们可以与更大的世界保持联系,也许可以继续工作,维持朋友和家庭关系。

接近语速

贝内特的步伐开始接近讲英语的人每分钟大约160个单词的自然对话速度,进行手术的外科医生Jaimie Henderson医学博士说。

“我们已经证明,你可以通过记录大脑表面非常小的区域的活动来解码预期的语音,”亨德森说。

亨德森是神经外科的约翰和让·布鲁姆-罗伯特和露丝·哈尔佩林教授,是8月23日发表在 《自然》杂志上的一篇描述结果的论文的共同资深作者。他的共同资深作者,电气工程和生物工程教授Krishna Shenoy博士在研究发表之前去世。

弗兰克·威利特博士是霍华德休斯医学研究所的科学家,隶属于神经假肢转化实验室,该实验室由亨德森和申诺伊于2009年共同创立,与研究生Erin Kunz和Chaofei Fan共享该研究的主要作者。

2021 年,亨德森、谢诺伊和威利特是发表在 《自然》杂志上的一项研究的合著者,该研究描述了他们使用 iBCI 将瘫痪者想象中的笔迹转换为屏幕上的文本的成功,速度达到每分钟 90 个字符或 18 个单词——这是迄今为止与 iBCI 相关的方法的世界纪录。

当Bennett了解到Henderson和Shenoy的工作时,她与Henderson取得了联系,并自愿参加了临床试验。

工作原理

亨德森植入贝内特大脑皮层(大脑最外层)的传感器是微小硅电极的方形阵列。每个阵列包含64个电极,排列成8×8的网格,彼此之间的距离约为信用卡厚度的一半。电极穿透大脑皮层的深度大致等于两个堆叠的四分之一。

植入的阵列连接到细金线上,这些细金线通过拧在头骨上的基座退出,然后通过电缆连接到计算机。

人工智能算法接收并解码来自贝内特大脑的电子信息,最终自学区分与她试图制定构成英语口语的39个音素中的每一个相关的不同大脑活动。它将关于Bennett尝试的音素序列的最佳猜测输入到所谓的语言模型中,本质上是一个复杂的自动更正系统,它将音素流转换为它们所代表的单词序列。

“这个系统经过训练,知道哪些单词应该出现在其他单词之前,以及哪些音素产生什么单词,”威利特解释说。“如果某些音素被错误地解释,它仍然可以很好地猜测。

熟能生巧

为了教算法识别哪些大脑活动模式与哪些音素相关联,贝内特进行了大约25次训练,每次持续约四个小时,在此期间,她试图重复从大型数据集中随机选择的句子,该数据集由打电话的人之间的对话样本组成。

举个例子:“过去五年才这样。“另一个:”我就在中间离开了。

当她试图背诵每个句子时,贝内特的大脑活动,由解码器翻译成音素流,然后由自动更正系统组装成单词,将显示在原文下方的屏幕上。然后屏幕上会出现一个新句子。

贝内特每次训练重复260到480个句子。整个系统不断改进,因为它熟悉了贝内特在演讲尝试期间的大脑活动。

iCBI的预期语音翻译能力在与培训课程中使用的句子不同的句子上进行了测试。当句子和单词组合语言模型被限制在50个单词的词汇量中时(在这种情况下,使用的句子是从特殊列表中提取的),翻译系统的错误率为9.1%。

当词汇量扩展到125,000个单词(大到足以组成几乎所有你想说的话)时,错误率上升到23.8% – 远非完美,但与先前的技术水平相比迈出了一大步。

“这是一个科学的概念证明,而不是人们可以在日常生活中使用的实际设备,”威利特说。“但这是恢复瘫痪患者无法说话的快速沟通的一大进步。

“想象一下,”贝内特写道,“当非语言的人可以实时交流他们的想法时,进行购物、参加约会、点餐、去银行、打电话、表达爱或欣赏——甚至争论——等日常活动将是多么不同。

本研究中描述的设备仅授权用于调查用途,不商业化。该研究是一项注册临床试验,在BrainGate的支持下进行,BrainGate是一个致力于推进BCI在假肢应用中使用的多机构联盟,由研究合著者Leigh Hochberg,医学博士,博士领导,他是隶属于马萨诸塞州总医院,布朗大学和弗吉尼亚州普罗维登斯(罗德岛)医疗保健系统的神经学家和研究员。

该研究由美国国立卫生研究院(资助U01-DC017844和U01-DC019430),美国退伍军人事务部,斯坦福吴仔神经科学研究所,HHMI,西蒙斯基金会以及拉里和帕梅拉·加里克资助。

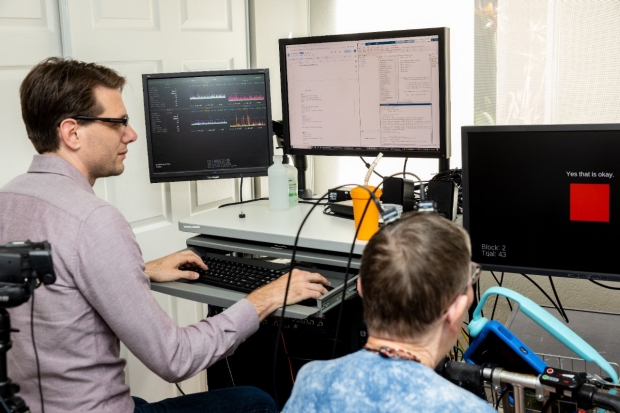

Image caption 在这里找到更多照片(图片来源:Steve Fisch/Stanford Medicine)。

文章旨在传播有益信息,英文版原文来自https://med.stanford.edu/news/all-news/2023/08/brain-implant-speech-als.html