超逼真的虚拟世界被誉为自动驾驶汽车(AVs)的最佳驾驶学校,因为它们已经被证明是安全试验危险驾驶场景的富有成效的试验台。特斯拉(Tesla)、Waymo和其他自动驾驶公司都严重依赖数据来实现昂贵且专有的逼真模拟器,因为测试和收集细微的i -几乎崩溃数据通常不是最容易或最理想的重现。

为此,麻省理工学院计算机科学和人工智能实验室(CSAIL)的科学家们创造了“VISTA 2.0”,这是一个数据驱动的模拟引擎,车辆可以在现实世界中学习驾驶,并从接近撞车的场景中恢复。更重要的是,所有的代码都是对公众开放的。

“今天,只有公司拥有像VISTA 2.0那样的模拟环境和能力的软件,而且这种软件是专有的。通过此次发布,研究界将获得一个强大的新工具,以加快自动驾驶自适应鲁棒控制的研究和开发,”麻省理工学院教授、CSAIL主任Daniela Rus说,他是一篇有关该研究的论文的资深作者。

VISTA 2.0基于该团队之前的模型VISTA,它与现有的AV模拟器有本质上的不同,因为它是数据驱动的——这意味着它是根据真实世界的数据构建和逼真地渲染的——因此能够直接转移到现实中。虽然最初的迭代只支持使用一个摄像头传感器的单辆汽车的车道跟踪,但实现高保真的数据驱动模拟需要重新思考如何综合不同传感器和行为交互的基础。

进入VISTA 2.0:一个数据驱动的系统,可以模拟复杂的传感器类型,大规模的交互场景和交叉点。由于数据比之前的模型少得多,该团队能够训练出比那些在大量真实数据上训练的自动驾驶汽车更健壮的汽车。

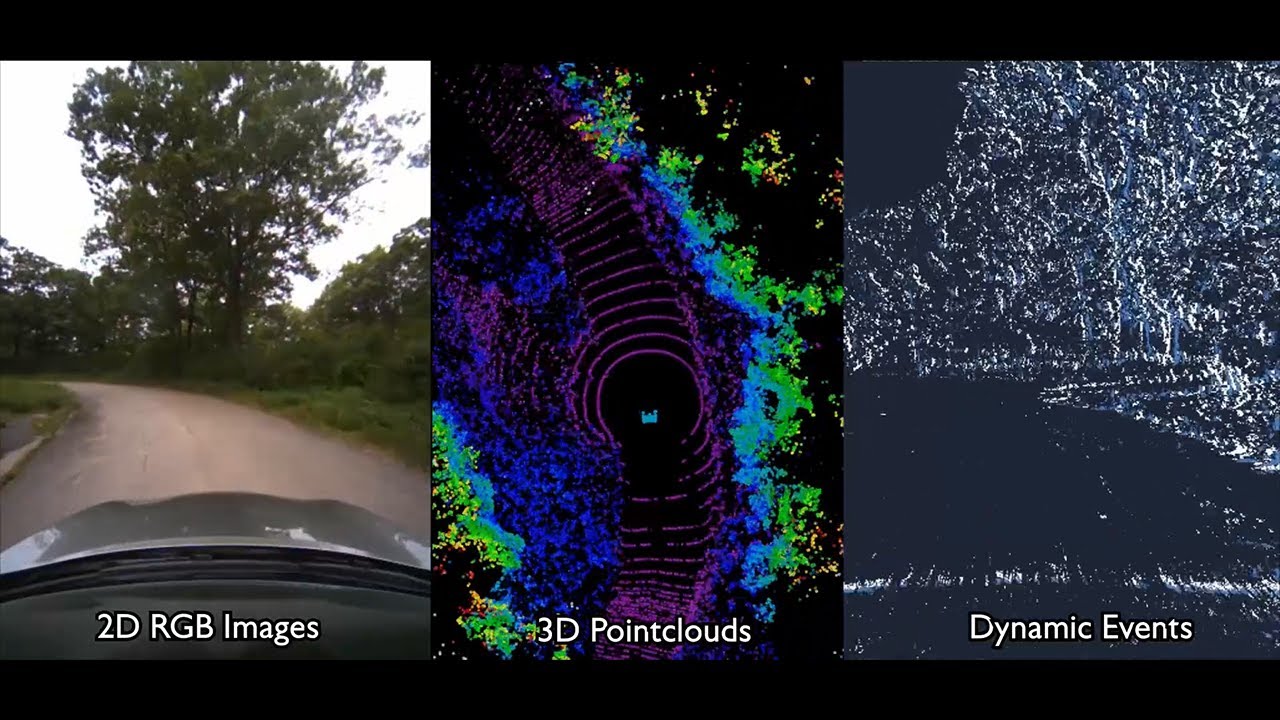

CSAIL博士生Alexander Amini说:“这是自动驾驶汽车数据驱动模拟能力的巨大飞跃,也是处理更复杂驾驶的规模和能力的增长。”他和他的同事jun – hsuan Wang是两篇新论文的共同主要作者。“VISTA 2.0展示了模拟传感器数据的能力,远远超过了2D RGB摄像头,以及具有数百万点的超高维3D激光雷达,不规则计时的基于事件的摄像头,甚至与其他车辆的交互式和动态场景。”

该团队能够衡量诸如超车、跟随和谈判等交互式驾驶任务的复杂性,包括高度逼真环境中的多智能体场景。

训练自动驾驶汽车的AI模型涉及各种边缘情况和奇怪、危险的场景,这很难确保安全,因为我们的大多数数据(谢天谢地)只是日常驾驶的普通数据。从逻辑上讲,我们不能为了教神经网络如何不撞到其他车而撞到其他车。

最近,人们开始从更经典的、人类设计的模拟环境转向从真实数据构建的模拟环境。后者具有巨大的真实感,但前者可以很容易地模拟虚拟相机和激光雷达。随着这种范式的转变,一个关键问题也随之出现:自动驾驶汽车需要的所有传感器的丰富程度和复杂性,比如更稀疏的激光雷达和基于事件的摄像头,能否准确地合成出来?

在一个数据驱动的世界中,激光雷达传感器数据的解释要困难得多——你只能从世界的稀疏视图中有效地生成包含数百万点的全新3D点云。为了合成3D激光雷达点云,该团队使用了汽车收集的数据,将其投影到一个来自激光雷达数据的3D空间中,然后让一辆新的虚拟车辆在原始车辆所在的地方附近行驶。最后,在神经网络的帮助下,他们将所有的感官信息投影到这款新型虚拟汽车的视野框架中。

基于事件的摄像头的模拟运行速度超过每秒数千个事件,与此一起,模拟器不仅能够模拟多模态信息,而且所有这些都是实时进行的——这使得离线训练神经网络成为可能,还可以在汽车上的增强现实设置中进行在线测试,以进行安全评估。阿米尼说:“在数据驱动模拟领域,如此复杂和逼真的多传感器模拟是否可行,这是一个悬而未决的问题。”

这样一来,驾校就变成了一个派对。在模拟过程中,你可以四处移动,使用不同类型的控制器,模拟不同类型的事件,创建交互场景,甚至可以在原始数据中添加全新的车辆。他们测试了车道跟随、车道转弯、车辆跟随,以及静态和动态超车(看到障碍物并移动以避免碰撞)等更危险的场景。在多代理系统中,真实的和模拟的代理都可以交互,新的代理可以被放入场景中并以任何方式进行控制。

把他们的全尺寸车开到“野外”——也就是马萨诸塞州的德文斯——团队看到了结果的可转移性,有失败也有成功。他们还展示了自动驾驶汽车模型的一个大胆而神奇的词:“强大”。他们展示了完全用VISTA 2.0训练的自动驾驶汽车在现实世界中是如此强大,以至于他们可以处理难以捉摸的具有挑战性的失败。

现在,人类依赖的一个护栏还不能被模拟,那就是人类的情感。它是友好的挥手、点头或眨眼的确认开关,这是团队希望在未来的工作中实现的细微差别类型。

阿米尼说:“这项研究的核心算法是,我们如何获得一个数据集,并为学习和自主建立一个完全合成的世界。”“我相信,有一天,这个平台可以扩展到机器人领域的许多不同领域。不仅仅是自动驾驶,还有许多依赖视觉和复杂行为的领域。我们很高兴发布VISTA 2.0,以帮助社区收集他们自己的数据集,并将它们转换成虚拟世界,在那里他们可以直接模拟自己的虚拟自动驾驶汽车,在这些虚拟地形上驾驶,在这些世界中训练自动驾驶汽车,然后可以直接将它们转移到完整尺寸的真正的自动驾驶汽车。”

Amini和Wang与麻省理工学院CSAIL博士生刘志坚共同撰写了这篇论文;多伦多大学计算机科学助理教授Igor Gilitschenski;Wilko Schwarting, AI研究科学家,麻省理工CSAIL博士20;麻省理工学院电子工程与计算机科学系副教授宋涵;麻省理工学院航空航天副教授Sertac Karaman;以及麻省理工学院教授、CSAIL主任Daniela Rus。研究人员在费城举行的IEEE机器人与自动化国际会议(ICRA)上展示了这项工作。

这项工作得到了美国国家科学基金会和丰田研究所的支持。团队通过捐赠Drive AGX Pegasus来感谢NVIDIA的支持。

文章旨在传播新闻信息,原文请查看https://news.mit.edu/2022/researchers-release-open-source-photorealistic-simulator-autonomous-driving-0621