人类的感觉系统非常擅长识别我们看到的物体或听到的单词,即使物体是颠倒的,或者单词是由我们从未听过的声音说出来的。

被称为深度神经网络的计算模型可以被训练做同样的事情,正确识别狗的图像,无论它的皮毛是什么颜色,或者一个单词,无论说话者的声音音调如何。然而,麻省理工学院神经科学家的一项新研究发现,这些模型通常也会以相同的方式响应与目标没有相似之处的图像或单词。

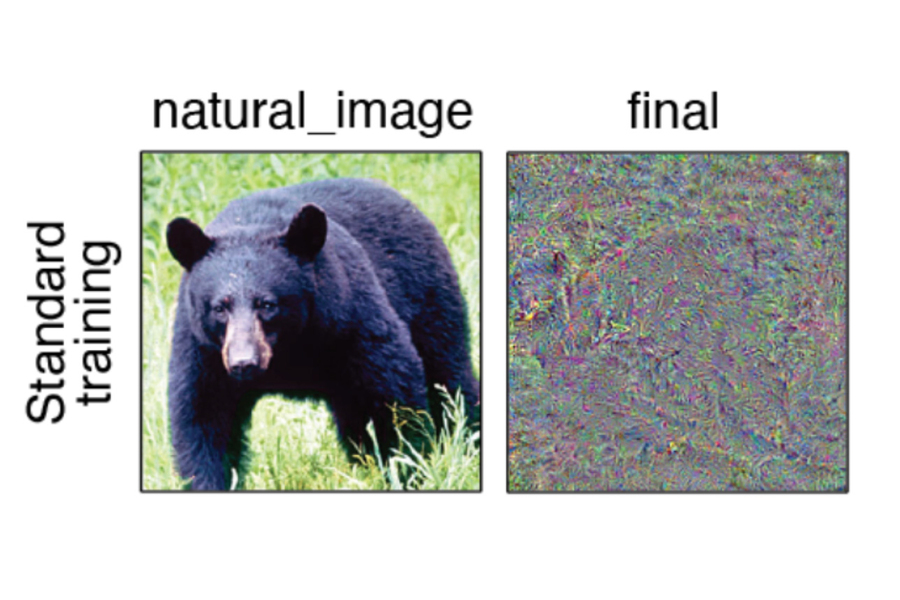

当这些神经网络被用来生成一个图像或一个单词,它们以与特定的自然输入(例如熊的图片)相同的方式做出反应时,它们中的大多数都会生成人类观察者无法识别的图像或声音。这表明这些模型建立了自己的特质“不变性”——这意味着它们对具有非常不同特征的刺激的反应方式相同。

这些发现为研究人员提供了一种评估这些模型如何模仿人类感官知觉组织的新方法,麻省理工学院大脑和认知科学副教授,麻省理工学院麦戈文脑研究所和大脑,思想和机器中心的成员Josh McDermott说。

“这篇论文表明,你可以使用这些模型来推导出不自然的信号,这些信号最终对模型中的表征非常具有诊断性,”该研究的资深作者麦克德莫特说。“这个测试应该成为我们作为一个领域用来评估模型的一系列测试的一部分。

Jenelle Feather PhD ‘ 22现在是Flatiron Institute Center for Computational Neuroscience的研究员,是开放获取论文的主要作者,该论文今天发表在 Nature Neuroscience上。麻省理工学院研究生Guillaume Leclerc和麻省理工学院Cadence设计系统计算教授Aleksander Mądry也是该论文的作者。

不同的认知

近年来,研究人员已经训练了深度神经网络,可以分析数百万个输入(声音或图像)并学习共同特征,使他们能够像人类一样准确地对目标单词或物体进行分类。这些模型目前被认为是生物感觉系统的主要模型。

人们相信,当人类感官系统执行这种分类时,它会学会忽略与物体核心身份无关的特征,例如有多少光线照射在它上面或从什么角度观看它。这被称为不变性,这意味着即使对象在这些不太重要的特征上表现出差异,它们也会被认为是相同的。

“传统上,我们对感觉系统的看法是,它们建立了对同一事物的不同例子可能具有的所有变异源的不变性,”Feather说。“一个有机体必须认识到它们是同一件事,即使它们表现为非常不同的感官信号。

研究人员想知道,经过训练以执行分类任务的深度神经网络是否会产生类似的不变性。为了试图回答这个问题,他们使用这些模型来产生刺激,这些刺激在模型中产生与研究人员给予模型的示例刺激相同的反应。

他们将这些刺激称为“模型同构体”,恢复了经典感知研究中的一个想法,即系统无法区分的刺激可用于诊断其不变性。同构体的概念最初是在人类感知研究中开发的,用于描述看起来相同的颜色,即使它们由不同波长的光组成。

令他们惊讶的是,研究人员发现,以这种方式产生的大多数图像和声音看起来和听起来都不像模型最初给出的例子。大多数图像都是一堆随机的像素,声音类似于难以理解的噪音。当研究人员向人类观察者展示图像时,在大多数情况下,人类不会将模型合成的图像与原始目标示例分类为同一类别。

“它们真的根本无法被人类识别。它们看起来或听起来不自然,也没有可解释的特征,人们可以用来对物体或单词进行分类,“Feather说。

研究结果表明,这些模型以某种方式发展了自己的不变性,与人类感知系统中发现的不变性不同。这导致模型将成对的刺激视为相同的,尽管它们与人类大不相同。

特质不变性

研究人员在许多不同的视觉和听觉模型中发现了相同的效果。然而,这些模型中的每一个似乎都发展了自己独特的不变性。当一个模型的同构体被展示给另一个模型时,第二个模型的同构体就像人类观察者一样无法识别。

“由此得出的关键推论是,这些模型似乎具有我们所说的特质不变性,”麦克德莫特说。“他们已经学会了在刺激空间中对这些特定维度不变,而且它是特定于模型的,所以其他模型没有同样的不变性。

研究人员还发现,通过使用一种称为对抗训练的方法,他们可以诱导模型的同构体更容易被人类识别。这种方法最初是为了克服对象识别模型的另一个限制而开发的,即对图像进行微小的、几乎察觉不到的更改可能会导致模型误认它。

研究人员发现,对抗性训练,包括在训练数据中包括其中一些略微改变的图像,产生了模型,其同构体更容易被人类识别,尽管它们仍然不如原始刺激那样可识别。研究人员说,这种改进似乎与训练对模型抵抗对抗性攻击能力的影响无关。

“这种特殊的训练形式有很大的影响,但我们真的不知道为什么它有这种效果,”Feather说。“这是未来研究的一个领域。

研究人员说,分析计算模型产生的同构体可能是一个有用的工具,可以帮助评估计算模型与人类感官感知系统潜在组织的模仿程度。

“这是一个行为测试,你可以在给定的模型上运行,看看模型和人类观察者之间是否共享不变性,”Feather说。“它还可用于评估给定模型中不变性的特殊性,这可能有助于发现未来改进我们模型的潜在方法。

该研究由美国国家科学基金会,国立卫生研究院,能源部计算科学研究生奖学金和麦戈文研究所之友奖学金资助。

新闻旨在传播有益信息,英文版原文来自https://news.mit.edu/2023/study-deep-neural-networks-perception-1016