被称为视觉和语言模型的强大机器学习算法,可以学习将文本与图像匹配,当被要求生成字幕或总结视频时,已经显示出显着的结果。

虽然这些模型擅长识别对象,但它们通常难以理解概念,例如对象属性或场景中项目的排列。例如,视觉和语言模型可能会识别图像中的杯子和桌子,但无法掌握杯子放在桌子上。

来自麻省理工学院、麻省理工学院-IBM沃森人工智能实验室和其他地方的研究人员展示了一种新技术,该技术利用计算机生成的数据来帮助视觉和语言模型克服这一缺点。

研究人员创建了一个合成图像数据集,描绘了各种场景、物体排列和人类行为,并附有详细的文本描述。他们使用这个带注释的数据集来“修复”视觉和语言模型,以便他们可以更有效地学习概念。他们的技术确保这些模型在看到真实图像时仍然可以做出准确的预测。

当他们测试概念理解模型时,研究人员发现他们的技术将准确性提高了10%。这可以改进自动为视频添加字幕的系统,或增强为图像问题提供自然语言答案的模型,并在电子商务或医疗保健等领域得到应用。

“通过这项工作,我们正在超越名词,因为我们超越了对象的名称,更多地涉及对象及其周围一切的语义概念。我们的想法是,当机器学习模型看到许多不同排列的物体时,它将更好地了解排列在场景中的重要性,“电气工程和计算机科学系的研究生Khaled Shehada说。

Shehada与主要作者Paola Cascante-Bonilla一起撰写了这篇论文,Paola Cascante-Bonilla是莱斯大学的计算机科学研究生;Aude Oliva,麻省理工学院苏世民计算学院战略行业参与主任,麻省理工学院-IBM沃森人工智能实验室主任,计算机科学与人工智能实验室(CSAIL)高级研究科学家;资深作者Leonid Karlinsky,麻省理工学院-IBM沃森人工智能实验室的研究人员;以及麻省理工学院、麻省理工学院-IBM 沃森人工智能实验室、佐治亚理工学院、莱斯大学、庞特学院、魏茨曼科学研究所和 IBM 研究院的其他机构。该论文将在计算机视觉国际会议上发表。

聚焦对象

视觉和语言模型通常学习识别场景中的对象,最终可能会忽略对象属性(如颜色和大小)或位置关系(如哪个对象位于另一个对象之上)。

这是由于这些模型经常被训练的方法,称为对比学习。这种训练方法涉及强制模型预测图像和文本之间的对应关系。在比较自然图像时,每个场景中的物体往往会引起最显着的差异。(也许一幅图片显示了田野里的一匹马,而第二张图片显示了水面上的帆船。

“每个图像都可以由图像中的对象唯一定义。所以,当你做对比学习时,只关注名词和宾语就能解决问题。为什么这个模型会做任何不同的事情?“Karlinsky说。

研究人员试图通过使用合成数据来微调视觉和语言模型来缓解这个问题。微调过程涉及调整已经训练的模型,以提高其在特定任务上的性能。

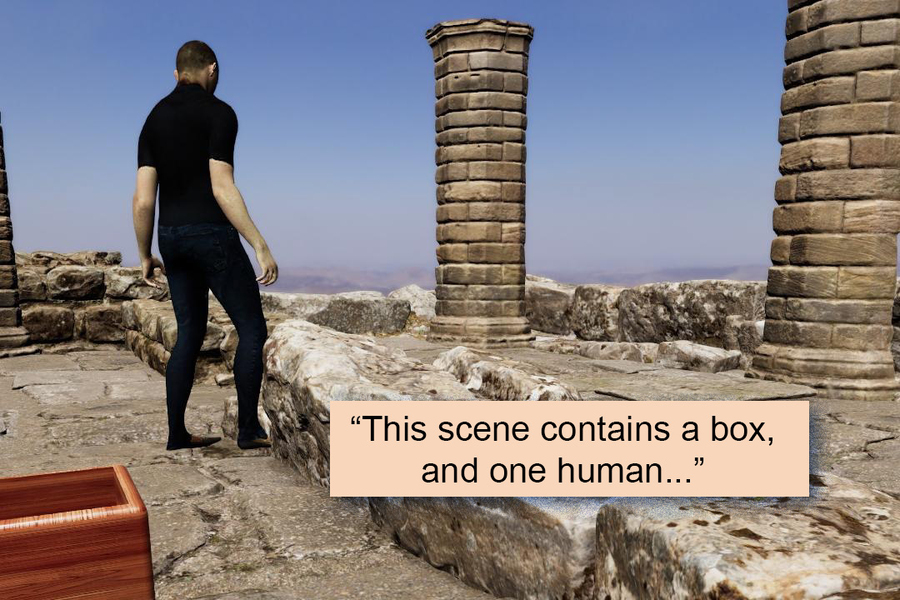

他们使用计算机自动创建具有各种3D环境和对象(如家具和行李)的合成视频,并添加与对象交互的人类化身。

使用这些视频的各个帧,他们生成了近800,000个逼真的图像,然后为每个图像与详细的标题配对。研究人员开发了一种注释图像各个方面的方法,以在密集的标题中清晰一致地捕获对象属性,位置关系和人与对象的交互。

因为研究人员创造了这些图像,他们可以控制物体的外观和位置,以及人类化身的性别、服装、姿势和动作。

“合成数据允许很多多样性。使用真实图像,你可能没有很多大象在一个房间里,但使用合成数据,如果你愿意,你实际上可以在一个房间里有一头粉红色的大象,“Cascante-Bonilla说。

合成数据还有其他优点。它们的生成成本比真实数据便宜,但图像非常逼真。它们还保护隐私,因为图像中没有显示真正的人类。而且,由于数据是由计算机自动生成的,因此可以快速生成大量数据。

通过使用不同的相机视点,或稍微改变物体的位置或属性,研究人员创建了一个数据集,其场景种类比自然数据集要广泛得多。

微调,但不要忘记

但是,当使用合成数据微调模型时,模型可能会“忘记”最初使用真实数据训练时所学的内容。

研究人员采用了一些技术来防止这个问题,例如调整合成数据,使颜色,照明和阴影更接近自然图像中的颜色,照明和阴影。他们还在微调后对模型的内部工作进行了调整,以进一步减少任何健忘。

他们的合成数据集和微调策略将流行视觉和语言模型准确识别概念的能力提高了10%。同时,模特们并没有忘记他们已经学到的东西。

既然他们已经展示了如何使用合成数据来解决这个问题,研究人员希望确定提高这些数据的视觉质量和多样性的方法,以及使合成场景看起来逼真的底层物理原理。此外,他们计划测试可扩展性的极限,并研究模型改进是否开始随着更大、更多样化的合成数据集而停滞不前。

这项研究部分由美国国防高级研究计划局、国家科学基金会和麻省理工学院-IBM沃森人工智能实验室资助。

新闻旨在传播有益信息,英文版原文来自https://news.mit.edu/2023/helping-computer-vision-language-models-see-0913